2025 用Cursor不如用国产大模型自己搭建!VSCode+Continue教程

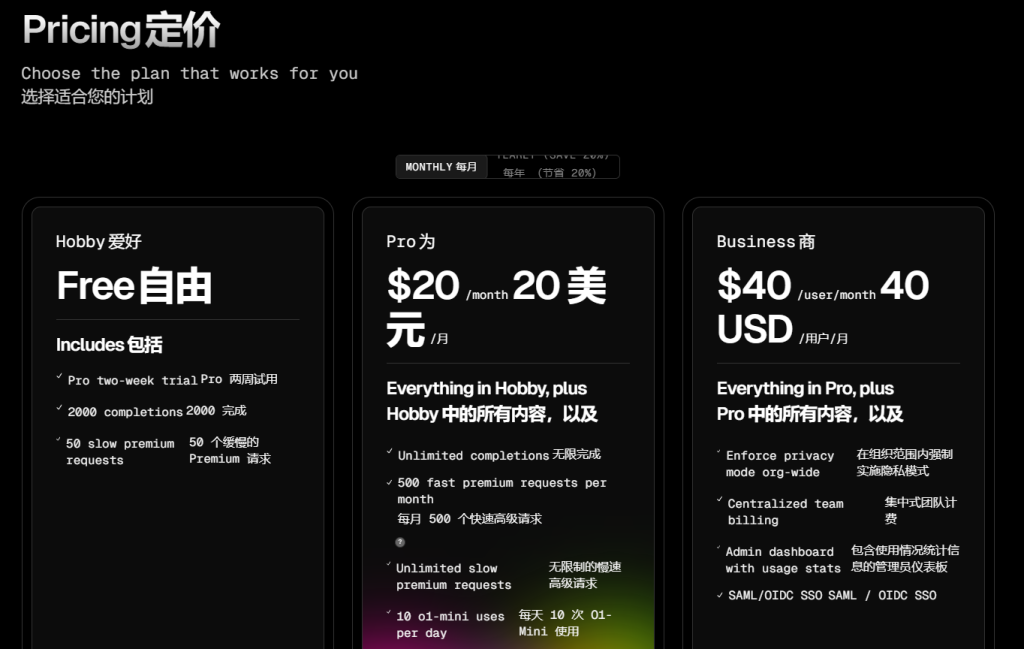

还在为Cursor每月20美刀,但平时用得不多而心痛吗?不可否认,Cursor的确很强,在AI编程辅助上目前应该还是是第一流的体验。而且至少除了价格以外,的确也用上了非常强大的模型(Claude3.5 sonnet-20241022/O1/GPT-4),集成了AI Agent模式,除了代码片段生成以外,已经在逐步往AI 工程师方向前进。

而他的竞争对手Github Copilot 以10美金/月的性价比持续迭代,最近也引入了Claude3.5 sonnet,o1-min和o1-preview,gemini1.5pro 等最强模型。我也是Copilot的第一批试用用户了,可惜他无故封号,AI会拒绝回答问题,让我十分恼火,就直接弃了。

到了2025,国产DeepSeek大模型春节成功出圈。

- 国产大模型以DeepSeek/Qwen在代码能力上已经拉平Claude3.5 sonnet-20241022等公认代码能力强大的模型,且价格便宜,不存在网络问题,也不会无缘故封号。

- AI功能应用上,开源届也已经跑出了不少好用可定制化的插件。如Continue,Cline等。

两则结合,以低成本定制化强大的编程助手已经可以赶上Cursor的体验,关键还是性价比高,还不受限制。

方案:VSCode + Continue插件 + DeepSeek-R1/Qwen2.5-max

- 选模型:

建议DeepSeek-V3,复杂问题用DeepSeek-R1,备选 Qwen2.5 max。因为DeepSeek官网被攻击以及需求大爆发后,官方的API非常不稳定,时断时续,体验比较糟糕。所以我们需要找多几个卖token的服务商,另外考虑到最近DeepSeek很火,各家都没有足够的资源,可能会有集中歇菜的情况,所以需要一个备选。Qwen2.5 max实测下来比DeepSeek-V3好些,比R1稍弱,但速度快,稳定服务,现在已经晋升成我的首选了。毕竟谁也不能忍受一个时不时抽风用不了的AI吧。

最后如果可以的话,需要国外的最新大模型,还可以考虑代理商。

2. 选服务商:

现在有大量的大模型平台都有DeepSeek等国产大模型的服务。

- DeepSeek官网

- 硅基流动(各种开源大模型,最近比较流行,但开始过载了)

- 百度千帆智能云(卖文心大模型以及DeepSeek)

- 阿里百炼大模型(卖Qwen,DeepSeek以及其他开源大模型,相对稳定点,毕竟是大型云厂商)

- 腾讯云TI(混元+DeepSeek,刚上线没多久)

- 火山方舟(豆包+DeepSeek,试用过,那会速度太慢,不知道补资源了没)

- OpenAI-HK(API代理商,有各大海外大模型,稳定,价格公道)

目前用下来,我基本使用Qwen2.5 max为主,其他平台因为需求量问题,都或多或少出现过回复慢,访问不稳定的情况。大家可以自行选择。

一般注册完成后,就是在各个平台上找到你想要的模型的名字,url地址以及创建API Key。要注意我们一般不使用SDK,采用OpenAI API兼容格式即可,所以不需要下载什么SDK单独开发。

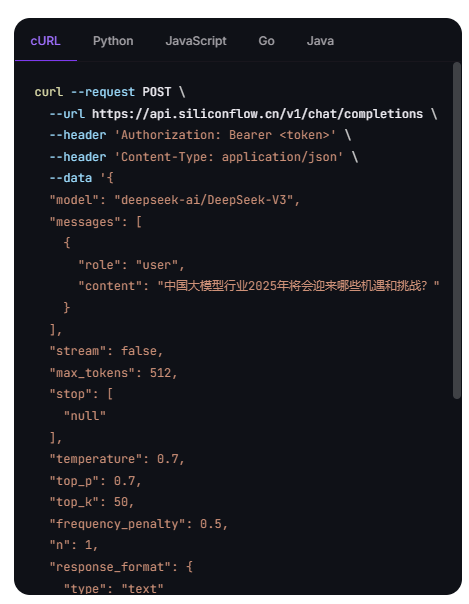

例如硅基流动SiliconFlow:

- 创建API Key

页面上可以方便创建和找到APIKey

2. API url

一般可以在文档里面找到:

一般直接看例子里面的curl请求的url参数即可。这里就是:

https://api.siliconflow.cn/v1

注意后续的/chat/completions 一般是插件自己完成,不需要填写3. 模型名,一般在模型选择入口就有,通常还会有个复制按钮,很容易找

PS:火山的模型名和URL和endpoint绑定,所以还有创建endpoint,对新手不算友好。

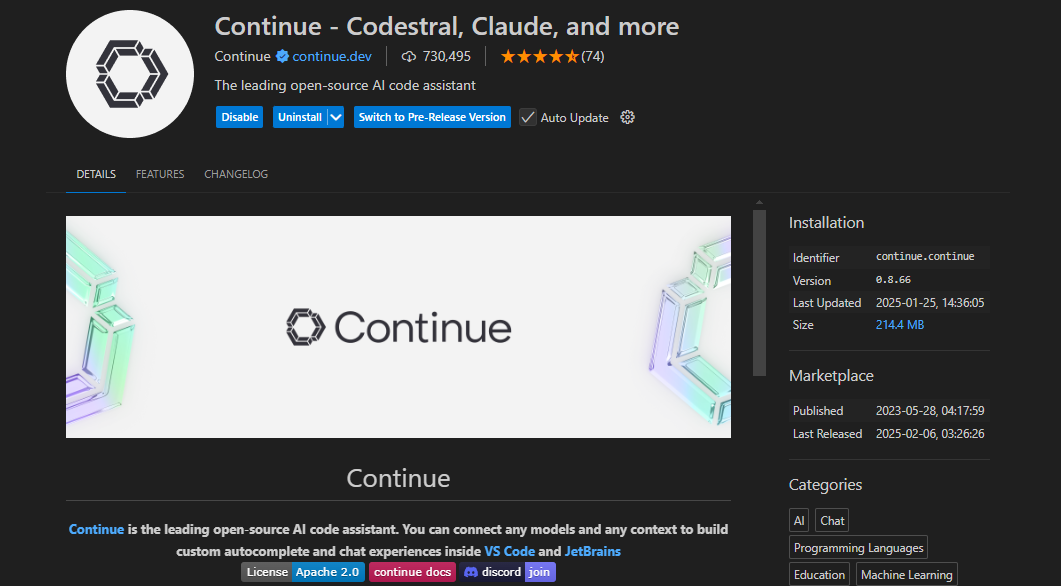

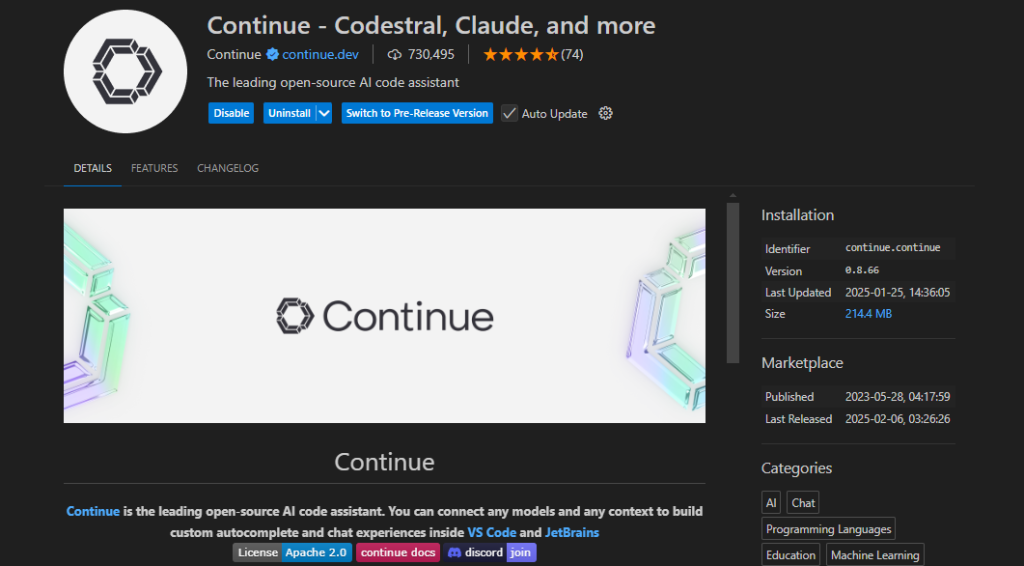

3. VSCode安装Continue

Continue是VSCode的一个本地插件(也支持远程开发,但不安装在远程机器上)

直接安装,重启VSCode即可

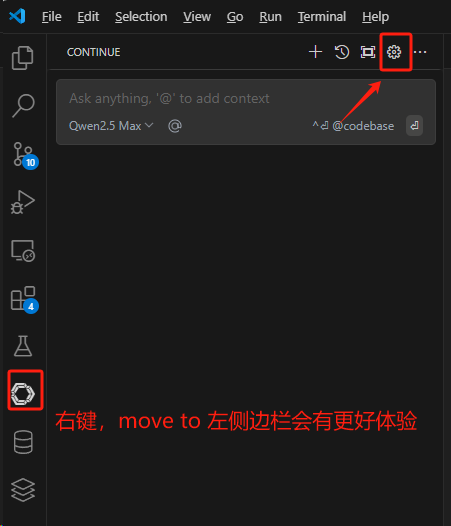

4. 配置

选择配置按钮,在config.json中配置即可:

"models": [

{

"title": "DeepSeek Chat",

"model": "deepseek-chat",

"contextLength": 64000,

"apiKey": "xxxxxx",

"provider": "deepseek"

},

{

"title": "DeepSeek Reasoner-siliconflow",

"model": "deepseek-ai/DeepSeek-R1",

"contextLength": 64000,

"apiKey": "xxxxxx",

"provider": "deepseek",

"apiBase": "https://api.siliconflow.cn/v1"

},

{

"title": "Qwen2.5 Max",

"model": "qwen-max-latest",

"contextLength": 32000,

"apiKey": "xxxxxxx",

"provider": "openai",

"apiBase": "https://dashscope.aliyuncs.com/compatible-mode/v1"

},

{

"title": "Claude3.5 Sonnet",

"model": "claude-3-5-sonnet-20241022",

"contextLength": 64000,

"apiKey": "xxxxxxx",

"provider": "openai",

"apiBase": "https://api.openai-hk.com/v1"

},

]

"tabAutocompleteModel": {

"title": "qwen-coder",

"provider": "siliconflow",

"model": "Pro/Qwen/Qwen2.5-Coder-7B-Instruct",

"apiKey": "xxxxxx"

},其中Models配置模型,首选各家大模型,DeepSeek/Qwen/Claude等最新模型。

tabAutocompleteModel配置自动补全模型,这里一般使用coder的小模型,更快,效果更好。我这里用的是Qwen2.5-Coder-7B-Instruct。

5. 使用

直接聊天,或者 ‘‘@’’文件,或者选中代码段Ctrl+L开始聊天,Ctrl+I让AI修改代码。

比如代码里面有看不懂的,直接选中,Ctrl+L让AI解释。

配置自动补全后,应该也会出现补全选项,直接tab补全。